개요

Online and Offline Reinforcement Learning by Planning with a Learned Model

(unplugged muzero)

(unplugged muzero)

학습할 데이터를 보다 효과적으로 활용할 수 있게 하는 reanalyse 알고리즘에 대한 이야기를 담고 있다.

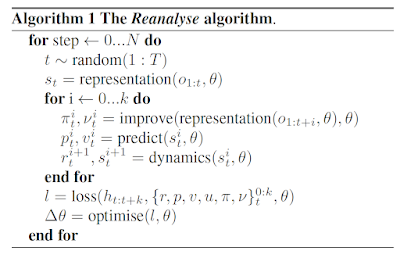

Reanalyse 알고리즘은 가진 데이터를 가지고 모델의 mcts로부터 improve하는 능력을 활용해 데이터를 재가공함으로써 보다 나은 성능을 낼 수 있게 한다.

Reanalyse 알고리즘 https://arxiv.org/abs/2104.06294

Target으로 쓰일 trajectory가 뮤제로처럼 데이터셋으로부터 그대로 펼쳐지는게 아니고

어느지점 한 시작지점(그지점 부터 약간 전의 observation들을 합친)으로부터 representation function으로 embedding하고 모델을 사용해 한 스텝 mcts서치로 얻은 search policy, search value

(그 다음은 그 다음 step의 observation이 추가된 observation들로부터 동일하게)

(action selection으로 env랑 상호작용 하지 않음)

와

시작지점부터 모델로 unroll한 것의 차이로 loss를 구해 학습하는 구조이다.

데이터셋에 존재하는 이전 data point에 가서 모델로 mcts를 돌려서 그곳에서 탐색을 돌려보는, reanalyze하는 모양이다.

해당 알고리즘은 offline RL에 효과적으로 사용이 가능하다. 또한 online RL과 병행해서 사용할 수도 있다. Online RL이든 offline RL이든 환경과 상호작용을 조금 덜 한다거나 가질 수 있는 데이터가 더 적거나 하는 경우에 보다 효율적으로 학습할 수 있으면 좋을 것이다.

Online RL, offline RL에 대한 설명, 출처 Offline Reinforcement Learning: Tutorial, Review,and Perspectives on Open Problems

Offline RL은 꼭 모델 자체가 상호작용하면서 얻은 데이터가 아니라 다른 agent로부터 얻어온 것이라던가, 사람이 한 데이터 등을 사용할 수 있다. 논문에서는 RL Unplugged benchmark for Atari and DM Control 데이터셋을 사용한다.

Reanalyse fraction 개념은 online - offline 비율을 조정할 수 있는 개념으로, 100% fraction인 경우 완전히 offline 학습하고, 0%면 완전히 온라인 학습한다. 적당히 조절함으로서 경우에 따라 사용할 수 있다.

Continuous Action Spaces에 대응하는 sampled muzero와 함께 사용할 수도 있다.

댓글

댓글 쓰기